L’ère des technologies numériques est en constante évolution, alimentée par des innovations sans cesse croissantes. Cela est particulièrement visible dans le domaine des processeurs, qui sont le cœur battant de nos appareils technologiques. Les avancées récentes sont fascinantes, et donnent un aperçu des tendances actuelles. Les fabricants de puces s’efforcent d’améliorer la performance, la consommation d’énergie et la capacité de traitement des données. L’intelligence artificielle et les capacités de calcul quantique ouvrent de nouvelles perspectives. Ensemble, ces facteurs dessinent un fascinant paysage technologique en constante transformation.

Processeurs : les dernières tendances décryptées

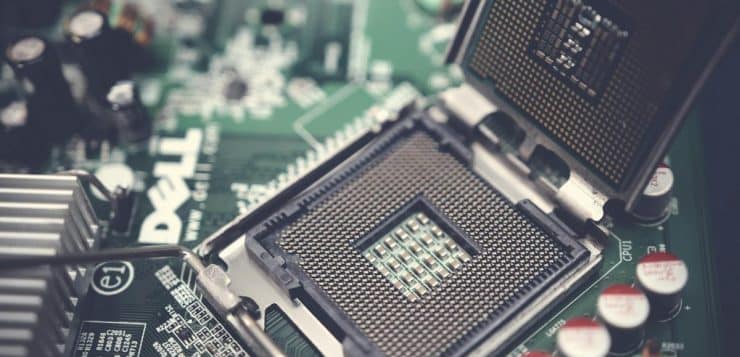

Les nouvelles tendances en matière de processeurs sont marquées par des avancées significatives dans divers domaines. L’une des tendances les plus importantes est la miniaturisation, avec l’introduction de processeurs toujours plus petits et efficaces. Cela permet non seulement d’améliorer les performances, mais aussi de réduire la consommation d’énergie.

A découvrir également : Projet Willow : dernières actualités et aperçu complet

Une autre tendance majeure est l’intégration de capacités d’intelligence artificielle (IA) directement au sein des processeurs. Ces puces dotées d’IA offrent une accélération importante dans le traitement des données complexes nécessaires à cette technologie émergente.

Parallèlement, les fabricants travaillent sur le développement de processeurs quantiques qui exploitent les propriétés uniques du monde subatomique pour effectuer des calculs encore plus rapidement que les ordinateurs classiques. Bien qu’en phase expérimentale, ces avancées ouvrent la voie à une nouvelle ère informatique.

A découvrir également : Installation GPU vertical : étapes clés pour réussir la configuration

Ces évolutions ne sont pas sans défis et enjeux. La principale préoccupation concerne la dissipation thermique due à l’augmentation constante du nombre de transistors intégrés aux puces. Effectivement, plus il y a de transistors, plus il faut dissiper la chaleur générée pour éviter toute surchauffe.

Alors que les besoins en puissance augmentent exponentiellement avec l’avènement de technologies telles que l’Internet des objets et la voiture autonome, il devient crucial pour les industriels du secteur de trouver des solutions durables et efficaces en termes d’alimentation électrique afin d’éviter les goulets d’étranglement.

Dans le futur, on peut s’attendre à des processeurs toujours plus puissants et économes en énergie grâce à l’utilisation de nouveaux matériaux tels que le graphène. Avec la démocratisation de l’informatique quantique, nous pourrions voir une révolution dans les domaines de la cryptographie et de la simulation moléculaire, entre autres.

Les nouvelles tendances en matière de processeurs témoignent d’une course effrénée vers des technologies toujours plus innovantes. La miniaturisation, l’intelligence artificielle intégrée et les avancées quantiques dessinent un avenir prometteur pour ces composants essentiels à notre vie numérique quotidienne. Ils posent aussi des défis majeurs tels que la dissipation thermique et la gestion de l’alimentation électrique. Il faut des processeurs performants et durables qui répondront aux besoins croissants du monde connecté d’aujourd’hui.

Les processeurs quantiques, contrairement aux processeurs classiques qui fonctionnent selon les lois de la physique classique, opèrent en exploitant les propriétés étranges et contre-intuitives de la physique quantique. Ces processeurs utilisent des bits quantiques, ou qubits, qui peuvent exister dans plusieurs états à la fois, offrant ainsi un potentiel de calcul massivement parallèle qui dépasse de loin ce que les processeurs classiques peuvent réaliser. Bien que l’informatique quantique en soit encore à ses premiers stades de développement, elle promet des avancées considérables dans des domaines tels que la cryptographie, l’optimisation, la modélisation de systèmes complexes et bien d’autres. L’investissement continu dans la recherche et le développement de cette technologie pourrait bien révolutionner l’informatique telle que nous la connaissons.